Введение

Контекст развития моделей ИИ и традиционные методы оценки

Оценка моделей является фундаментальной частью работы специалистов в области машинного обучения и искусственного интеллекта. В последние годы быстрое развитие моделей глубокого обучения и других алгоритмов на основе больших данных привело к массовому появлению исследований, в которых авторы демонстрируют улучшение своих моделей по различным метрикам. Традиционно такие показатели, как точность, полнота, F1-мера и другие, служили основным способом сравнительного анализа и выбора оптимальных решений. Однако, несмотря на кажущиеся положительные результаты, существует серьезная проблема — эти метрики не всегда отражают истинное качество и применимость моделей в реальных сценариях.

Для специалистов в AI и разработчиков важно понимать, что простое улучшение по оценке моделей не всегда означает действительно значимый прогресс. Более того, нередко такие улучшения могут быть результатом ошибок в методологии или недобросовестного использования данных. Важно критически подходить к оценке и интерпретации результатов, чтобы избежать ложного представления о качестве и потенциальной пользе новых решений.

Проблематика — почему простое улучшение по «оценке моделей» не всегда интересно

Причина, по которой одних лишь улучшений метрик недостаточно, кроется в сложности и многогранности реальных задач. Модель может показывать высокие показатели на заранее отобранных тестовых данных, но вести себя совершенно иначе в продуктивной среде с изменяющимися условиями. Стандартные метрики часто не учитывают такие аспекты, как устойчивость к шумам, интерпретируемость результатов или способность адаптироваться к новым, ранее не встречавшимся данным.

Это создает иллюзию прогресса, приводящую к неоправданному доверию и инвестициям в решения, которые на практике оказываются менее эффективными. Поэтому автоматические и поверхностные улучшения по оценке моделей должны вызывать у профессионалов искусственного интеллекта здоровый скепсис и стать поводом для более глубокого и многомерного анализа.

Критический анализ современных практик оценки моделей

Ограничения стандартных метрик и узкая направленность оценки моделей

Стандартные метрики, широко используемые в машинном обучении — такие как accuracy, precision, recall или AUC ROC — изначально предназначены для конкретных задач и условий. Тем не менее, их универсализация и повсеместное применение без учета специфики данных и бизнес-контекста приводит к ограниченному восприятию эффективности модели.

Одной из основных проблем является то, что многие исследования используют одни и те же наборы данных для обучения и тестирования, что ведет к переобучению. Модель отлично распознаёт особенности учебной выборки, но не справляется с новыми, вариативными данными из реального мира. Такая ситуация снижает объективность оценки и порождает недооценку рисков при внедрении.

Кроме того, большинство стандартных показателей не отображают устойчивость модели к изменениям входных данных, что критично в динамичной среде AI. Они также не учитывают интерпретируемость и объяснимость прогнозов — важные качества для обеспечения прозрачности и доверия к системам ИИ.

Иллюзия прогресса: когда рост по метрикам не отражает реальных преимуществ

Нередко исследователи публикуют результаты с улучшением в 1-2% по метрикам, что на первый взгляд кажется значимым. Однако такие улучшения могут быть статистически незначимыми или обусловлены «эффектом множественных тестов» (p-хакингом). Этот эффект возникает, когда множество экспериментов увеличивает вероятность случайного ложноположительного результата. Например, при проведении 20 тестов с уровнем значимости 95% случайно может получиться один «успешный» результат.

Это приводит к ситуации, когда статистическая значимость результатов поверхностно подтверждается, но реальное улучшение отсутствует. В результате рынок и профессиональное сообщество получают ложное впечатление о прогрессе, что снижает доверие к исследованиям в целом и усложняет внедрение действительно эффективных технологий.

В дополнение к этому, недостатки в методологии, такие как отсутствие полноценной валидации, неправильный выбор контрольных групп и траспарентности данных, ещё сильнее усугубляют ситуацию снижения качества оценки моделей.

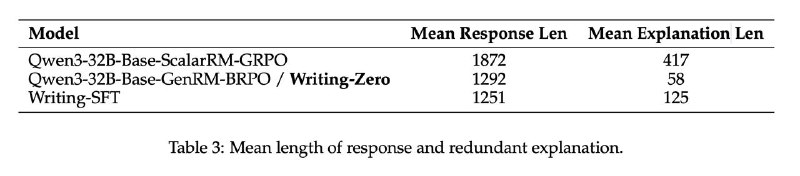

Пример: сравнение улучшений моделей по различным метрикам

| Метрика | Исходное значение | Заявленное улучшение | Комментарий |

|---|---|---|---|

| Accuracy | 85.2% | 86.4% | Рост на 1,2%, но без проверки на новых данных |

| F1-мера | 0.78 | 0.81 | Улучшение незначительно, возможен эффект случайности |

| ROC AUC | 0.91 | 0.92 | Растёт, но риск переобучения на тренировочном датасете |

Подобные сравнительные данные иллюстрируют, что небольшие улучшения по стандартным метрикам могут не гарантировать значимого повышения качества модели в реальных условиях.

Альтернативные подходы и глубокий взгляд на качество моделей

Контекстуальная и многомерная оценка: расширение критериев анализа

Для устранения узкой направленности стандартных метрик необходимо перейти к более комплексной оценке моделей, которая учитывает контекст применения и разнообразие факторов. Многомерный подход предполагает использование дополнительных критериев, таких как:

- Устойчивость к шумам и изменениям данных;

- Объяснимость результатов и возможность интерпретации модели;

- Время отклика и вычислительные ресурсы для работы;

- Оценка влияния на бизнес-процессы и конечных пользователей;

- Выявление и предотвращение переобучения посредством разнообразных техник кросс-валидации;

- Масштабируемость и адаптивность к изменениям в данных;

- Этические и правовые аспекты использования модели.

Такой подход позволяет получить более адекватную и информативную картину реальной эффективности модели, а также снизить вероятность ошибок при её внедрении.

Метрики устойчивости и интерпретируемости: что стоит добавить к оценке

Новые метрики все чаще нацелены на выявление слабых мест моделей, которые не фиксируются традиционными параметрами. Среди них можно выделить следующие:

- Robustness score — оценивает способность модели работать с зашумленными или изменёнными данными.

- Explainability index — измеряет степень прозрачности модели, например, с помощью методов SHAP или LIME.

- Latency and throughput — время обработки запросов, критично для онлайн-сервисов.

- Data drift sensitivity — отслеживает деградацию качества модели при сдвиге в распределении данных.

- Fairness metrics — анализируют наличие предвзятости по различным социальным или демографическим группам.

Включение этих метрик в процесс оценки позволяет сделать более сбалансированный и практичный выбор модели.

Практические рекомендации и перспективы развития

Разработка комплексных систем оценки моделей для профессионалов

Специалистам и компаниям, работающим с искусственным интеллектом, следует применять системный и комплексный подход к оценке моделей, который включает следующие практики:

- Использование нескольких, независимых наборов данных для обучения, валидации и тестирования;

- Применение методов кросс-валидации и стратифицированных сплитов для борьбы с переобучением;

- Внедрение статистических поправок на эффект множественных тестов для снижения ложных позитивов;

- Комбинирование количественных метрик с качественным анализом интерпретируемости и устойчивости;

- Регулярный аудит моделей и обратная связь с конечными пользователями для выявления скрытых проблем;

- Мониторинг моделей в продуктивной среде с применением MLOps инструментов для своевременного выявления деградации;

- Использование специализированных фреймворков для оценки этики и справедливости моделей.

Также важно внедрять инструменты автоматизированного мониторинга оценки моделей в продакшене, позволяющие отслеживать деградацию качества и своевременно принимать меры по дообучению или улучшению. Подробнее о практиках MLOps вы можете узнать в нашей статье «Лучшие практики MLOps в современной разработке ИИ».

Тенденции и вызовы в развитии критериев оценки моделей для ИИ-сообщества

Современное сообщество искусственного интеллекта всё активнее осознаёт необходимость перехода от простых метрик к более комплексным, отражающим реальную эффективность и безопасность ИИ-систем. Среди основных трендов выделяются:

- Разработка стандартов и протоколов комплексной оценки моделей с учётом этических, юридических и технических аспектов;

- Повышенное внимание к интерпретируемости и ответственному искусственному интеллекту (Explainable AI, Responsible AI);

- Создание публичных benchmark-датасетов с реальными сценариями и противодействие переобучению на «знакомых» данных;

- Рост использования метрик, измеряющих устойчивость моделей к атакам и сдвигу данных (data drift);

- Интеграция оценки моделей в процессы DevOps и MLOps для повышения качества и прозрачности;

- Акцент на обеспечение прозрачности и воспроизводимости результатов исследований.

Текущие вызовы связаны с необходимостью баланса между сложностью оценки и практической применимостью подходов, а также с развитием инфраструктуры и инструментов, поддерживающих эти задачи. Подробнее о современных вызовах и решениях можно прочитать в нашем обзоре «Вызовы и перспективы развития искусственного интеллекта».

Для более детального понимания методологии оценки моделей рекомендуем ознакомиться с материалами в нашем блоге по теме эффективности моделей машинного обучения и методам тестирования ML-алгоритмов.

Дополнительные рекомендации и современные исследования по данной теме можно найти на платформе arXiv.org, где раскрыты проблемы методики и пути их решения.

FAQ: оценка моделей

- Почему простое улучшение по метрикам не всегда означает прогресс?

Потому что многие метрики не учитывают устойчивость модели к новым данным и реальному контексту, а улучшения могут быть статистически незначимы из-за эффекта множественных тестов. - Как бороться с переобучением при оценке моделей?

Необходимо использовать независимые тестовые наборы, методы кросс-валидации и следить за балансом между точностью на обучении и тестах. - Что такое интерпретируемость модели и зачем она нужна?

Интерпретируемость позволяет понять логику решений модели, что важно для доверия, аудита и регулирования AI-систем. - Какие новые подходы используются для оценки моделей?

Включают многомерный анализ, показатели устойчивости, объяснимость, а также интеграцию оценки в MLOps-процессы. - Где можно найти стандарты и руководства по оценке моделей?

На официальных ресурсах, таких как NIST AI RMF и международных организациях по стандартизации в области ИИ.

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.