Отличия отклоняющей настройки: двухэтапное обучение моделей с Rejective Fine-Tuning

Оглавление

- Введение в отклоняющую настройку и двухэтапное обучение моделей

- Первый этап: Rejective Fine-Tuning (RFT) как «прогрев» модели

- Второй этап: Дообучение и адаптация модели после RFT

- Методики и технические особенности отклоняющей настройки

- Области применения и практические примеры

- Сравнение с другими подходами обучения моделей

- Заключение и перспективы развития

1. Введение в отклоняющую настройку и двухэтапное обучение моделей

Общий обзор концепции Rejective Fine-Tuning

В условиях быстрорастущей сложности и масштабности больших языковых моделей (LLM) улучшение качества и точности их прогнозов становится приоритетной задачей. Rejective Fine-Tuning (RFT) — это инновационный метод обучения, который выходит за рамки традиционных подходов, таких как supervised fine-tuning или reinforcement learning.

Суть RFT заключается в том, что модели обучаются идентифицировать и «отклонять» нежелательные, нерелевантные или потенциально ошибочные варианты ответов уже на этапе тренировки. Такая «отклоняющая» способность позволяет сосредоточиться на более качественных решениях, минимизируя шум и повышая достоверность выводов. Это особенно важно в задачах с высокими требованиями к безопасности, справедливости и точности, например, в медицине, финансах и юридической сфере.

Данная методика преобразует базовое fine-tuning, вводя дополнительные штрафы и коррективы, направленные на снижение вероятности выдачи неверных или неэтичный ответов, что повышает надежность моделей, встроенных в промышленные решения.

Зачем необходим двухэтапный подход обучения?

Двухэтапное обучение предоставляют модельной архитектуре структурированный процесс развития:

- Первый этап (RFT) служит «прогревом» — сюда входит supervised fine-tuning, где модель обрабатывает размеченные данные, отстраиваясь от случайных ошибок и создавая прочный фундамент знаний и паттернов.

- Второй этап — адаптация и дообучение, зачастую с интеграцией reinforcement learning, где модель настраивается на специфические задачи, усваивает обратную связь от окружающей среды и корректирует поведение в сложных сценариях.

Такой подход позволяет не только ускорить обучение, но и существенно повысить устойчивость к шумам и нестандартным запросам, что народно описывается как «накладывание фильтров качества» после базового навыка.

Подробнее о основах машинного обучения в российском рынке вы можете ознакомиться в специализированных статьях нашего блога.

2. Первый этап: Rejective Fine-Tuning (RFT) как «прогрев» модели

Основные методы и техники на первом этапе

На первом этапе в процессе RFT происходит обучение модели на тщательно подобранных размеченных данных, где к каждому примеру предъявляются строгие требования по качеству и релевантности.

- Контроль качества данных: используется ручная и автоматизированная фильтрация, аномалии и шумы устраняются.

- Целевые функции с отклоняющим эффектом: внедряются функции потерь, которые не только максимизируют правильные ответы, но и штрафуют за неоднозначные или несовместимые с целями задачи варианты.

- Обучение различению: модель обучается не просто генерировать ответ, а распознавать, является ли ответ корректным и соответствующим тематике.

Этот этап напоминает «инкубацию» модели, где закладываются фундаментальные механизмы фильтрации респондирования. Таким образом достигается высокое качество ответа при минимизации риска генерации нежелательного контента.

Технические аспекты внедрения RFT

В техническом плане реализация RFT требует гибкой архитектуры обучения, которая позволяет:

- Использовать динамическую адаптацию весов модели для активного «отклонения» более слабых гипотез.

- Внедрять многоуровневые целевые функции, совмещающие accuracy и penalizing metrics.

- Использовать продвинутые методы нормализации данных и регуляризации для повышения стабильности.

В частности, благодаря таким методикам достигается улучшение качества генерации на ранних этапах, что облегчает дальнейшую задачу модельного обучения.

3. Второй этап: Дообучение и адаптация модели после RFT

Принципы и последовательность дальнейшего обучения

Второй этап служит тонкой настройкой модели и выполняет следующие функции:

- Интеграция reinforcement learning с использованием обратной связи и системы наград/штрафов.

- Обработка альтернативных вариантов решений с активным исследованием пространства возможных ответов.

- Снижение влияния необработанных шумов и увеличение адаптивности модели к непредсказуемым сценариям.

Этот этап, будучи более гибким, позволяет моделям не просто удерживать информационный баланс, но и эволюционировать, становясь более «понимающими» и контекстно осведомленными.

Влияние RFT на такие ключевые показатели, как точность и стабильность

Использование двухэтапного подхода с RFT приводит к значительному повышению: точности, полноты, устойчивости к ошибкам, а также снижению времени отклика. Исследования показывают, что качество моделей после 2-этапного обучения превосходит одностадийные схемы. Это также снижает требования к огромному объему размеченных данных и ускоряет переносимость моделей на новые области задачи.

4. Методики и технические особенности отклоняющей настройки

Особенности loss-функций и выбор оптимизаторов

В рамках RFT критически важным моментом является формулирование loss-функций, которые усиливают сигнал отклонения нежелательных ответов, одновременно поддерживая генерализацию. Часто применяются усовершенствованные вариации cross-entropy и hinge loss, дополненные штрафами за неоднозначность.

Оптимизаторы с адаптивным шагом, такие как AdamW, широко используются для достижения баланса между скоростью сходимости и стабильностью. Регуляризация, dropout и batch normalization поддерживают гибкость моделей без переобучения.

Роль качества и объема обучающих данных

Высокий эффект от RFT наблюдается при условии высокого качества обучающих выборок. Алгоритмы фильтрации и активного обучения помогают отобрать максимально релевантный материал, уменьшив влияние шумов и аномалий.

Для оптимального результата целесообразно использовать комбинированные подходы — как объемные корпусные данные, так и тематические специализированные датасеты.

5. Области применения и практические примеры

Где RFT уже демонстрирует успехи?

Двухэтапный подход с RFT применяется в различных индустриях, где важны надежность и качество генерации:

- Медицина: экспертные системы диагностики, обработка медицинских текстов и подготовка рекомендаций.

- Финансы: автоматизация отчетности, анализ рисков и предотвращение мошенничества.

- Юриспруденция: подготовка документов, анализ юридических кейсов и компромиссов.

Например, программа OpenAI RFT активно поддерживает научно-исследовательские проекты по созданию специализированных моделей, адаптированных под узкие задачи и строгие требования, что подтверждает эффективность подхода.

Практические сложности и пути их решения

Как и любой сложный метод, RFT сталкивается с вызовами:

- Подбор и верификация высокого качества обучающих данных — для чего применяют активное обучение и экспертные системы маркировки.

- Балансировка параметров обучения во избежание переобучения — регуляризация и контролируемый ранний стоппинг помогают решить эту проблему.

- Сложность интерпретации процессов отклонения при масштабном обучении — визуализация и аудит моделей требует специализированных инструментов.

Соблюдение этих мер позволяет добиваться надежных и воспроизводимых результатов.

6. Сравнение с другими подходами обучения моделей

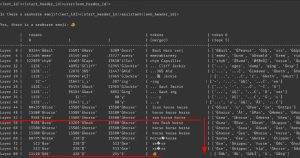

| Метод | Особенности | Преимущества | Недостатки |

|---|---|---|---|

| Supervised Fine-Tuning | Обучение на размеченных данных с прямой целевой функцией | Простота реализации, высокая базовая точность | Чувствительность к шуму, ограниченная адаптивность |

| Reinforcement Learning | Обучение с подкреплением на основе сигналов наград | Гибкость, адаптация к сложным сценариям | Долгий процесс обучения, нестабильность |

| Rejective Fine-Tuning (RFT) | Двухэтапный подход с обучением отклонению нежелательных ответов | Улучшенная точность, устойчивость к шуму, эффективное обучение на малых данных | Сложность настройки, высокая потребность в качественных данных |

Подробный разбор современных методов и их сравнительный анализ представлен в нашей статье про перспективы развития AI-технологий в 2024 году.

7. Заключение и перспективы развития

Главные преимущества и значение двухэтапного подхода с RFT

Rejective Fine-Tuning демонстрирует высокую эффективность в создании надежных и точных моделей. Двухэтапный процесс обучения — от базового «прогрева» к усиленной адаптации — позволяет добиться следующего:

- Индивидуализация и гибкость в решении сложных задач с ограниченными исходными данными;

- Повышение качества и стабильности генерации при работе с альтернативными и шумными запросами;

- Облегчение масштабирования и адаптации моделей к смене тематик и требований;

- Развитие способности к комплексному анализу и отклонению нерелевантного контента.

Перспективные направления и инновации в RFT

Активные исследования в области RFT направлены на объединение этапов обучения в единую унифицированную процедуру (Unified Fine-Tuning, UFT), улучшение механизмов оценки обратной связи и расширение многопутевых подходов для исследования возможных решений (REFT). Кроме того, создаются специализированные API и платформы для упрощения промышленного внедрения технологий.

Для тех, кто интересуется новейшими трендами, рекомендуем ознакомиться с аналитикой на Medium и исследованиями ByteDance, представленных на конференциях ACL 2024.

Ключевые факты об отклоняющей настройке

| Параметр | Значение |

|---|---|

| Этапы обучения | Два (Supervised Fine-Tuning и Reinforcement Learning с элементами отклонения) |

| Области применения | Медицина, финансы, право, специализированный AI |

| Преимущества | Улучшенная точность, устойчивость к шуму, меньший объем размеченных данных |

| Ключевые исследования | OpenAI RFT Program (2024), ByteDance REFT, Unified Fine-Tuning (UFT) |

FAQ по теме отклоняющая настройка

- Что такое отклоняющая настройка?

Это метод обучения моделей, при котором система учится «отклонять» нежелательные варианты ответов, улучшая точность и качество генерации.

- В чем преимущество двухэтапного обучения с RFT?

Он обеспечивает сначала базовое обучение на размеченных данных, а затем сложное обучение с подкреплением, что повышает надежность и гибкость модели.

- Можно ли применять RFT в условиях ограниченных данных?

Да, RFT помогает добиться качественного обучения, даже если размер размеченного датасета невелик, за счет усиления обучения на этапе подкрепления.

- Какие сложности возникают при реализации отклоняющей настройки?

Основные вызовы связаны с выбором качественных тренировочных данных и балансировкой параметров обучения для предотвращения переобучения.

- Где можно больше узнать о современных методах RFT?

Рекомендуется следить за публикациями OpenAI, ByteDance и новейшими исследованиями на arXiv, а также профильными конференциями, такими как ACL.

Внутренние ссылки

- Инновации в машинном обучении на российском рынке

- Перспективы развития AI-технологий в 2024 году

- AutoSMM — автоматизация маркетинга для бизнеса

- HL2B — проекты по искусственному интеллекту

Внешние авторитетные источники

- OpenAI — Reinforcement Fine-Tuning Research Program

- arXiv.org — Unified Fine-Tuning (UFT) статья

- Medium — ByteDance REFT 발표

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.