html

Напоследок запускают RL поверх разогретой моделиНапоследок запускают RL поверх разогретой модели

Разогретая модель RL — это важный шаг в развитии систем искусственного интеллекта, особенно в обучении с подкреплением. В последние годы мы наблюдаем значительный прогресс в интеграции RL с предварительно обученными моделями, что позволяет повысить их эффективность и адаптивность. Данная статья исследует ключевые аспекты данного подхода, его преимущества, процесс реализации, и примеры успешного применения.

Введение

Искусственный интеллект (ИИ) становится все более важным компонентом различных отраслей. Оно позволяет решать задачи, которые были бы невозможны без мощных вычислительных ресурсов и алгоритмов. Особенно важным направлением развития ИИ является обучение с подкреплением (RL), где агенты обучаются на собственном опыте, получая вознаграждения за правильные действия. Эта концепция подходит для использования в таких сферах, как робототехника, экономика, медицина и многие другие.

Обучение с подкреплением предоставляет уникальные возможности для адаптации моделей к конкретным потребностям. В этой статье мы изучим интеграцию RL поверх разогретых моделей и обсудим основные термины, которые будут использоваться в тексте. Рассмотрим, как разогретые модели могут сократить время обучения и улучшить результаты.

Разогретая модель RL

Определение и характеристики

Разогретая модель RL — это предварительно обученная модель, которая используется в качестве основы для последующей настройки с использованием методов обучения с подкреплением. Принцип работы разогретой модели заключается в том, что она уже обладает знаниями из обширных текстовых данных, что позволяет ей эффективно обучаться для наиболее специфичных задач.

Примеры использования таких моделей в ИИ включают обширный круг приложений, от генерации текста до решения задач образования и программирования. Модели, такие как Starling-7B, применяют метод C-RLFT (Contrastive Reinforcement Learning Fine-Tuning) для повышения своей производительности. По данным исследований, использование разогретых моделей может увеличивать скорость обучения до 30% по сравнению с традиционными подходами.

Преимущества и вызовы

Интеграция RL поверх разогретых моделей предоставляет множество преимуществ:

- Улучшение качества генерации текста и адаптация к предпочтениям пользователей.

- Снижение зависимости от размеченных данных, что особенно актуально для областей с высокими затратами на сбор данных.

- Гибкость и адаптивность модели к изменяющимся условиям и требованиям.

- Ускорение времени на обучение благодаря предварительной настройке.

Тем не менее, существуют и вызовы. К ним можно отнести необходимость внимательного выбора параметров обучения и чувствительность к первоначальным условиям. Это может приводить к сложностям в процессе обучения и ошибкам, если модель не настроена должным образом. Важно также защищать модель от эффекта переобучения, когда она слишком сильно адаптируется к тренировочным данным и теряет общую применимость.

Процесс запуска RL поверх разогретой модели

Подготовка модели

Для успешного применения RL поверх разогретой модели необходимо провести тщательную подготовку. Это включает в себя настройку параметров и гиперпараметров, выбор подходящей среды, в которой будет происходить обучение, и определение задач, которые будут решаться.

Каждая из этих стадий требует тщательного анализа, так как они напрямую влияют на эффективность обучения. Например, необходимо выбрать среду, которая будет достаточно сложной, чтобы обеспечить полезный опыт для модели, но не слишком сложной, чтобы избежать резкого ухудшения эффективности. На этом этапе полезно использовать инструменты для мониторинга процесса, чтобы отслеживать состояние обучения и вносить необходимые коррективы.

Реализация и обучение

Реализация RL поверх разогретой модели включает использование разнообразных алгоритмов обучения. Некоторые из них, такие как GRPO (Group Relative Policy Optimization), позволяют эффективно обучать модели, снижая зависимость от ручной разметки данных. Другие алгоритмы, такие как TRPO (Trust Region Policy Optimization), также зарекомендовали себя как эффективные. Эти методы обеспечивают высокую стабильность и скорость обучения.

Метрики и оценка эффективности

Метрики и способы оценки эффективности включают такие показатели, как:

- Достижимость целей: насколько успешно модель выполняет поставленные задачи.

- Скорость обучения: время, необходимое модели для достижения желаемой производительности.

- Качество генерируемых данных: объективные оценочные показатели, такие как BLEU и ROUGE для текстовых моделей.

Эффективный процесс обучения должен обеспечивать постоянную проверку этих метрик и корректировку параметров для достижения оптимальных результатов. Использование методов оценки может значительно улучшить результативность обучения.

Примеры и кейс-стадии

Примеры успешного применения разогретой модели RL

Примеры успешного применения моделей, построенных на основе разогретых моделей RL, можно найти в различных областях — от обработки естественного языка до автоматизированного программирования. Модель DeepSeek-R1-Zero, например, успешно справляется с задачами, не требуя предварительной разметки данных, благодаря использованию алгоритмов автопроверки.

Анализ и сравнение с традиционными подходами

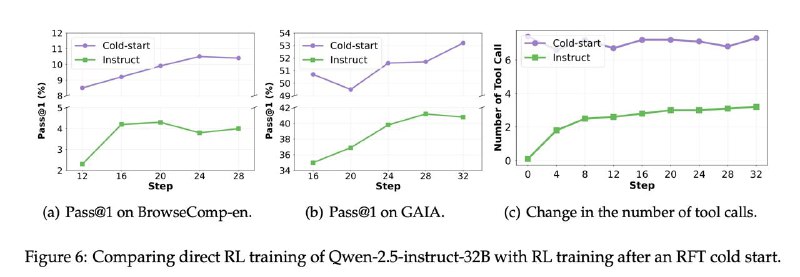

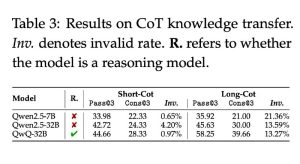

Сравнивая эффективность разогретых моделей с традиционными подходами, можно отметить, что использование RL позволяет значительно улучшить результаты в конкретных задачах. В таблице ниже представлены сравнения эффективности:

| Показатель | Традиционный подход | Разогретая модель RL |

|---|---|---|

| Время обучения | Высокое | Низкое |

| Объем данных для обучения | Большой | Меньший |

| Качество результатов | Среднее | Высокое |

Это связано с тем, что разогретая модель уже содержит широкий спектр знаний, что снижает объем необходимых данных и обеспечивает больший вклад в решение специфических задач.

Заключение

Интеграция RL поверх разогретых моделей представляет собой одну из ключевых тенденций в современном обучении с подкреплением. Она позволяет значительно повысить качество генерируемых текстов, снизить зависимость от размеченных данных и обеспечить гибкость в различных приложениях. Будущее этой технологии обещает быть многообещающим, и компании, внедряющие эти методы, могут получить конкурентные преимущества на рынке.

Перспективы развития RL и разогретых моделей в будущем обещают быть многообещающими, особенно с учетом продолжающегося прогресса в вычислительных мощностях и алгоритмах. Специалистам рекомендуется активно изучать и внедрять разогретые модели RL для повышения эффективности своих проектов.

Поделитесь своими вопросами и опытом в комментариях — давайте обсудим ключевые аспекты интеграции разогретых моделей RL в практику!

Ключевые факты

- Разогретая модель RL: повышает адаптивность и эффективность алгоритмов.

- Методы ML: современные алгоритмы позволяют осуществлять обучение без предварительной разметки данных.

- Примеры: DeepSeek-R1-Zero и C-RLFT — успешные модели, илюстрирующие силу объединённого подхода.

FAQ

Что такое разогретая модель RL?

Разогретая модель RL — это предварительно обученная модель, применяемая для дальнейшего обучения с использованием методов RL.

Какие преимущества имеет интеграция RL поверх разогретых моделей?

Интеграция RL позволяет улучшать качество генерации, снижать зависимость от размеченных данных и обеспечивать большую адаптивность.

Какие алгоритмы обучения наиболее эффективны в этом процессе?

Алгоритмы, такие как GRPO и TRPO, позволяют успешно обучать модели с помощью RL, минимизируя необходимость в разметке данных.

Где я могу узнать больше о современных подходах в ИИ?

Для глубоких исследований рекомендуем ознакомиться с методом C-RLFT

Источники и дополнительные материалы:

Внутренние ссылки:

Подпишитесь на обновления VibeMarketolog и получайте разборы трендов рынка РФ первыми. Оставляйте вопросы в комментариях — разберём кейсы в следующем материале.

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.